저사양의 기기에서도 거대언어모델(LLM)을 구동하는 최적화 서비스 공식 오픈

기존 하드웨어 교체 없이 빠른 추론 속도와 높은 성능 구현 ‘눈길’

노타가 거대언어모델(LLM) 최적화 서비스를 공개했다.

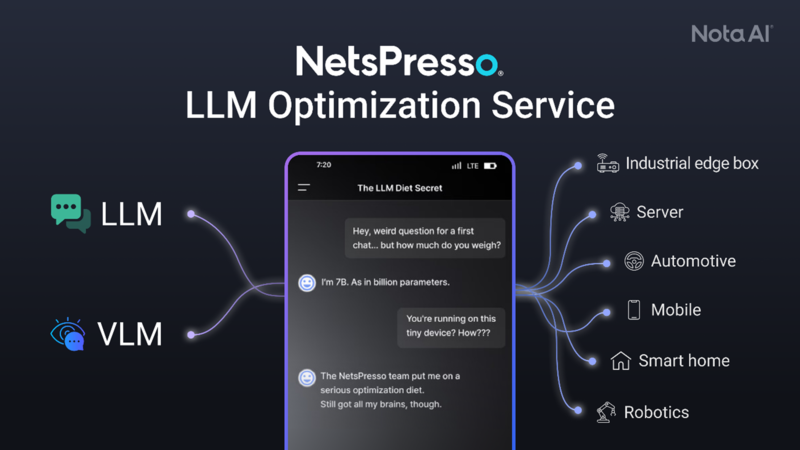

이번 서비스는 저사양의 기기에서도 거대언어모델(LLM)을 구현하는 기술로, 디바이스 사양에 관계 없이 LLM과 시각언어모델(VLM)을 최적화하는 점이 특징이다. 사측은 모델의 성능은 유지하면서도 빠른 추론 속도를 가능하게 하는 것을 핵심 강점으로 내세운다.

해당 기술은 생성형 AI(Generative AI)가 하드웨어에 빠르게 적용되는 시장 환경에 맞춰, 클라우드 및 온디바이스(On-device) 환경 등에서 자유롭게 구동된다. 노타 측은 가전제품·모빌리티 등 하드웨어 교체 비용이 부담되는 기업들이 최신 성능의 LLM 서비스를 도입하게 됐다고 강조했다.

또한 다양한 칩셋에서 호환이 가능하고, 복잡한 파라미터를 가진 LLM의 높은 최적화 난이도에 대응할 수 있다. 경량화를 통해 메모리·연산 효율을 향상시키고, LLM 사용에 따른 디바이스 전력 및 클라우드 운영 비용 절감 효과 또한 강점이다. 더불어 기존 하드웨어를 그대로 활용하기 때문에 별도의 인프라 투자 없이 새로운 LLM 모델을 적용할 수 있다는 점에서, 비용 효율성과 기술 경쟁력 확보에 유리할 것으로 보인다.

채명수 노타 대표는 “이번 LLM 최적화 서비스는 다양한 AI 모델을 실제 하드웨어에 최적화해 온 노타의 경험을 기반으로 개발됐다”며 “별도의 하드웨어 교체 없이 최신 언어모델을 안정적으로 적용해 비용 부담을 줄이고, 동시에 한층 향상된 사용자 경험을 제공할 수 있다는 점에서 차별화된 의미가 있다”라고 밝혔다.

헬로티 최재규 기자 |