래블업이 미국에서 열리는 ‘AI Infra Summit 2025’에 참가해 AI 인프라 운영의 미래를 제시했다. 이번 행사는 전 세계 3500여 명의 AI 전문가와 100여 개 파트너사가 모이는 글로벌 최대 규모의 AI 인프라 컨퍼런스로, 하드웨어부터 데이터센터, 엣지 컴퓨팅까지 최신 기술 동향이 집중적으로 다뤄졌다.

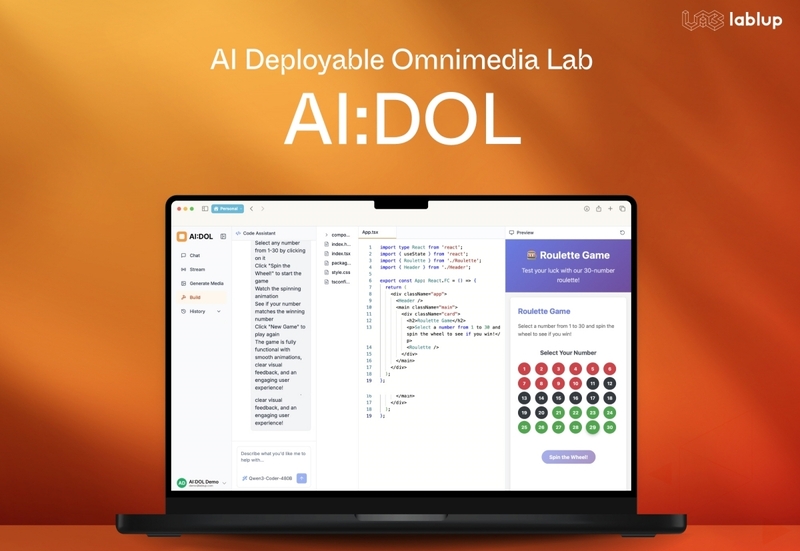

래블업은 이번 행사에서 자사의 AI 네이티브 플랫폼 ‘AI:DOL(AI Deployable Omnimedia Lab)’ 베타 버전을 첫 공개했다. AI:DOL은 Backend.AI Core와 PALI 기반 백엔드 서비스를 결합한 생성형 AI 개발 플랫폼으로, 웹 브라우저만으로 접근이 가능해 초보자부터 숙련된 개발자까지 손쉽게 다양한 오픈모델을 활용할 수 있도록 설계됐다.

특히 AI:DOL은 Backend.AI Continuum을 통해 온프레미스와 클라우드 자원을 완전히 통합해 사용자가 직접 서빙하는 모델을 기반으로 내부 및 외부 클라이언트 대상 AI 애플리케이션을 개발·배포할 수 있다. 현재는 채팅 중심의 기능을 제공하지만, 향후 이미지와 비디오 생성, AI 코딩까지 확장해 포괄적 AI 개발 생태계로 발전시킬 계획이다.

래블업은 또한 Backend.AI의 확장성과 운영 효율성을 현장에서 시연했다. NVIDIA Jetson Orin Nano 기반의 미니 AI 팩토리를 통해 소형 에지 디바이스에서 최대 1500대 GPU 규모의 하이퍼스케일 데이터센터까지 동일한 플랫폼으로 관리할 수 있음을 보여준 것이다. 특히 모듈러 컴퓨팅 기반의 스케일 아웃 기능, 이기종 AI 가속기 관리, GPU 분할 가상화 기술 등을 선보여, 한 장의 GPU를 다수의 가상 GPU로 나누고 다양한 AI 모델을 동시에 실행할 수 있는 차별화된 역량을 증명했다.

이번 발표에서 래블업은 모든 조직이 AI 인프라를 효율적으로 운영할 수 있도록 장벽을 낮추는 전략도 강조했다. 신정규 대표는 “글로벌 시장에서 AI 주권에 대한 관심이 높아지고 있으며, 다양한 하드웨어를 안정적으로 연동·운영하는 것이 여전히 큰 과제”라며, Backend.AI가 이를 해결하는 플랫폼으로서 소규모부터 초대규모까지 유연한 확장성과 높은 운영 효율성을 제공한다고 설명했다.

더불어 래블업은 과학기술정보통신부가 추진하는 ‘한국형 소버린 AI’ 프로젝트에도 참여 중이다. 업스테이지 컨소시엄의 일원으로 SK텔레콤의 해인 클러스터에서 NVIDIA B200 GPU 기반 인프라를 Backend.AI로 운영하며, 대규모 파운데이션 모델 훈련의 안정성과 가속화를 지원하고 있다. 이를 통해 정부의 독자 AI 생태계 구축에 기여하는 동시에, 글로벌 경쟁력 강화를 위한 대규모 AI 훈련 기술을 공개하고 있다.

래블업의 이번 행보는 AI 인프라 운영의 새로운 패러다임을 제시했다는 점에서 의미가 크다. 에지 디바이스에서 국가 규모의 데이터센터까지 아우르는 확장성, AI:DOL을 통한 포괄적 개발 환경, 그리고 글로벌 협력을 통한 기술 경쟁력 확보는 래블업이 향후 AI 인프라 시장에서 차별화된 입지를 굳히는 데 핵심이 될 것으로 보인다.

헬로티 서재창 기자 |