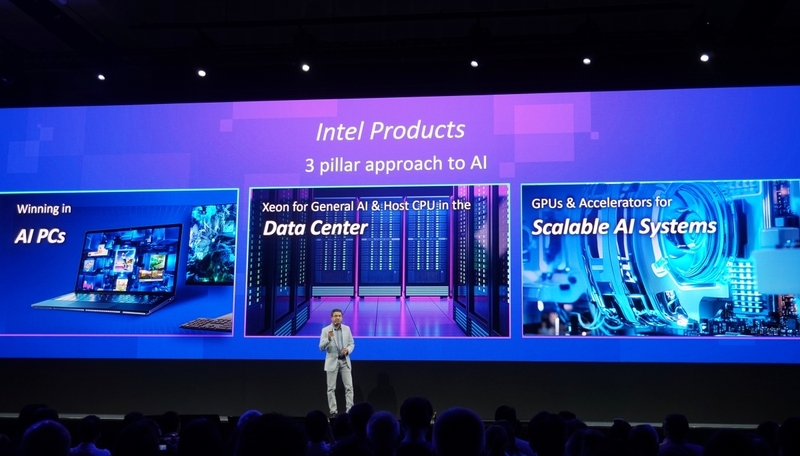

AI PC, 데이터 센터, 가우디 3 중심으로 한 AI 시스템 등 전략 공개해

인텔이 '컴퓨텍스 2025'에서 새로운 기술 패러다임에 대응하기 위한 전략을 대대적으로 공개했다.

사우라브 쿨카니(Saurabh Kulkarni) 인텔 데이터센터 AI 전략 및 제품 담당은 컴퓨텍스 2일차에 진행된 기술 포럼에 연사로 참여해 에이전틱 AI(Agentic AI)를 중심으로 변화하는 데이터 센터의 역할과 요구에 맞춘 맞춤형 인프라 구축 방향, 클라이언트와 엣지에서의 효율적 AI 활용 방안까지 폭넓은 기술 청사진을 제시했다.

이번 발표는 단순한 반도체 기술을 넘어 소프트웨어-하드웨어 통합 생태계 구축에 초점을 맞추며, 인텔이 차세대 AI 환경을 선도하려는 의지를 드러냈다. 자사의 ‘제온(Zeon) 6 프로세서’와 ‘가우디(Gaudi) 3’ 라인업, 클라이언트용 ARC 시리즈 등은 각 분야에서의 실질적 수요와 적용 가능성을 모두 반영했다. 인텔 역시 AI의 가치가 추론에 있음을 강조하며, 전 영역에 걸친 인프라 확장을 바탕으로 고객에게 새로운 비즈니스 가능성을 약속했다.

이러한 관점에서 사우라브 쿨카니는 ‘프런티어 AI 데이터 센터(Frontier AI Data Center)’라는 개념을 제시했다. 기존의 전통적 데이터 센터가 CPU 기반 일반 연산 위주였다면, 지금은 대규모 AI 모델을 실시간으로 운용하도록 최적화한 아키텍처가 요구된다. 에이전틱 AI라는 개념 아래, 인텔은 AI의 주요 기능인 인식, 추론, 행동, 지속학습 4단계를 중심으로 시스템 설계를 추구했다. 특히, 소프트웨어 우선 접근법을 강조한 인텔은 최종 사용자가 상호작용하게 되는 소프트웨어 레이어가 모든 인프라 설계의 출발점임을 강조했다.

발표에서 강조된 또 하나의 핵심 축은 클라이언트 및 엣지 디바이스에서의 AI 적용 확대다. 특히 AI PC 시대를 위한 ARC 시리즈의 진화는 눈여겨볼 부분이다. 사우라브 쿨카니는 자사의 클라이언트 프로세서에 AI 연산 기능을 직접 통합해 로컬 환경에서 실시간으로 데이터를 분석하고 활용하도록 설계했다고 언급했다. 그는 "현재 ARC 시리즈는 수천만 대 규모로 출하되며, 다양한 파트너 생태계를 통해 기능성과 호환성을 꾸준히 확장 중이다"고 말했다.

특히 900여 개 AI 모델과 5000명 이상의 개발자가 활발하게 참여하는 생태계는 인텔의 클라이언트 AI 기술이 시장에서 실질적으로 활용되고 있음을 보여줬다. 여기에 AI 어시스턴트 빌더(AI Assistant Builder)와 같은 툴도 공개돼 누구나 손쉽게 AI 에이전트를 구축하고 PC에 탑재하는 길이 열렸다.

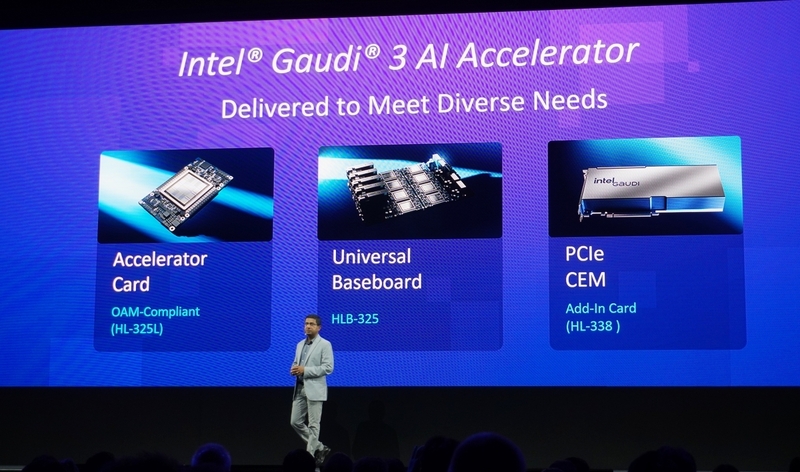

인텔은 대규모 AI 시스템을 위한 가우디 3 제품군도 강화하고 있다. 이 라인업은 대형 언어 모델(LLM)과 복잡한 추론 시나리오에 대응하도록 설계된 가속기 기반 인프라다. OAM 모듈과 PCIe 카드, 유니버설 베이스보드(UBB) 형태로 제공되는 가우디 3는 최대 8개의 가속기를 하나의 UBB 보드에 장착하며, 이를 통해 랙 단위로 수십 개의 가속기를 연결하는 대규모 도메인 구성이 가능하다.

한 예로, 인텔은 IBM과의 협업으로 가우디 3 기반의 인스턴스를 클라우드 환경에서 운영 중이며, 그 결과 최대 2.5배의 비용 대비 성능 우위를 달성했다고 밝혔다. 특히 입력 길이가 짧고 출력이 긴 LLM 시나리오에서 기존 경쟁 제품 대비 약 30% 높은 효율을 기록한 점은 주목할 만하다. 가우디 3는 추론뿐 아니라 학습에도 적합하며, 추후 32개~64개의 가속기를 지원하는 확장형 아키텍처도 예정돼 있다. 이는 최대 1조 파라미터를 초과하는 초거대 모델 학습까지 대응하는 수준이다.

기술 외적으로도 인텔은 개방형 생태계를 중요한 가치로 설정했다. 사우라브 쿨카니는 "우리는 단일 기업 중심의 폐쇄형 구조가 아닌, 다양한 소프트웨어 및 하드웨어 파트너와의 협업으로 생태계 전반의 경쟁력을 끌어올리는 데 초점을 두고 있다. 현재 인텔은 200개 이상의 독립 소프트웨어 벤더(ISV), 수백 개의 AI 모델 개발자, 수천 명의 애플리케이션 개발자와 긴밀한 협력 체계를 구축 중이다"고 말했다.

이러한 생태계는 단순히 인텔 제품의 판매를 넘어, 실질적인 사용성과 성과 중심의 비즈니스 모델을 가능하게 한다. 특히 인텔은 PyTorch, ONNX, Hugging Face 등 주요 AI 프레임워크에 대한 지원을 강화하며, 자체 소프트웨어 스택을 통해 다양한 제품군 간 호환성과 성능 최적화를 달성하고 있다.

AI 활용의 결정적인 순간은 결국 추론 결과에 달려 있다는 인텔의 철학 아래, 클라우드-엣지-클라이언트를 아우르는 연속적인 추론 플랫폼을 구축하려는 이들의 전략은 명확하다. 이처럼 인텔은 기술, 인프라, 생태계를 아우르는 접근으로 AI 시대의 주도권과 자존심을 확보하려고 한다.

헬로티 서재창 기자 |