가우디 3의 첫 대규모 상업 배포 사례...인프라 접근성 높일 것으로 보여

인텔이 IBM과 손잡고 자사 AI 가속기인 ‘인텔 가우디 3’를 클라우드 서비스에 최초로 상용 적용한다고 밝혔다.

IBM 클라우드는 주요 클라우드 서비스 제공사 중 처음으로 가우디 3를 기반으로 한 AI 서비스 환경을 개시했으며, 이로써 고객들은 고성능 AI 인프라를 보다 합리적인 비용으로 활용할 수 있는 기회를 갖게 됐다.

이번 상용화는 가우디 3의 첫 대규모 상업 배포 사례로, 생성형 AI 서비스 확산을 위한 인프라 접근성을 크게 끌어올리는 계기가 될 전망이다. 인텔과 IBM은 고가의 특화 하드웨어가 필요한 AI 연산 환경에서 비용 효율이라는 기준을 제시하며, 보다 많은 기업이 AI 기술을 실질적으로 도입하도록 협력하고 있다.

가우디 3는 생성형 AI와 대규모 언어모델 추론, 파인튜닝 등 고성능 연산을 요구하는 워크로드를 지원하도록 설계됐다. 특히 멀티모달 LLM, RAG(검색 증강 생성) 등 최신 AI 트렌드에 최적화된 아키텍처를 기반으로 한다. 개방형 개발 프레임워크 지원 또한 가우디 3의 장점 중 하나로, 다양한 개발 환경에 유연하게 대응할 수 있다는 평가다.

인텔에 따르면 가우디 3는 IBM 클라우드의 독일 프랑크푸르트, 미국 워싱턴 D.C., 텍사스 댈러스 리전에서 사용할 수 있다. 기업 고객은 IBM 클라우드 가상 서버(VPC)를 통해 이를 접속할 수 있으며, 오는 하반기부터 다양한 아키텍처에 배포가 가능해질 예정이다. 레드햇 오픈시프트(Red Hat OpenShift) 및 IBM 왓슨엑스(watsonx) AI 플랫폼과의 통합도 이뤄질 예정이다.

IBM은 이번 인텔과의 협력으로 금융, 의료, 생명과학, 공공 등 규제 산업 고객들이 안정성과 성능을 동시에 확보한 AI 환경을 구축할 수 있을 것이라 보고 있다. 실제로 금융 기관은 사기 탐지 및 맞춤형 서비스, 의료기관은 AI 기반 진단과 신약 개발, 유통 기업은 재고 관리와 이커머스 최적화 등에 클라우드 기반 AI 기술을 적극 활용 중이다.

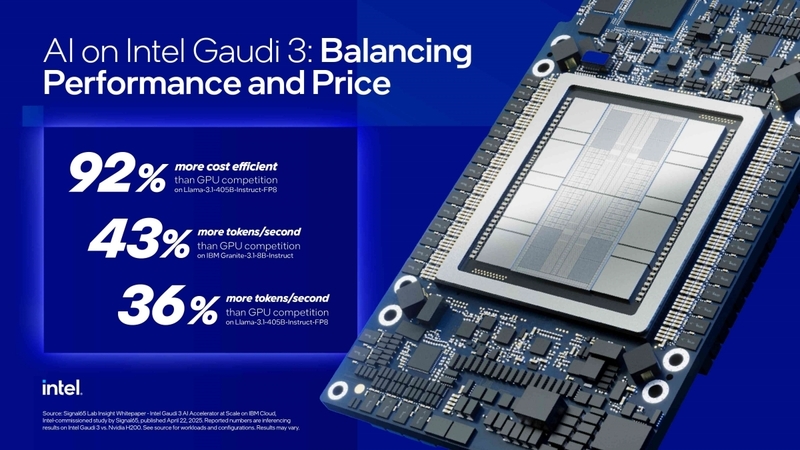

무엇보다 이번 협력은 AI 도입 시 가장 큰 걸림돌이었던 ‘비용’ 문제를 실질적으로 해결하는 데 의의가 있다. 조사기관 시그널65(Signal65)가 인텔 의뢰로 진행한 AI 추론 성능 벤치마크 결과에 따르면, 가우디 3는 메타의 Llama-3.1-405B-Instruct-FP8 모델 기준으로 경쟁 제품 대비 최대 92% 높은 비용 효율성을 보였다. 동일한 예산으로 더 많은 연산을 수행하거나, 같은 연산을 더 낮은 비용으로 처리할 수 있다는 의미다.

또한 처리량 측면에서도 우수한 수치를 기록했다. IBM의 Granite-3.1-8B-Instruct 모델 기반 소규모 워크로드에서는 초당 토큰 처리량이 43% 높았으며, Llama-3.1-405B 기준 대용량 워크로드에서도 36% 이상의 향상을 보였다. 이는 생성형 AI를 도입하거나 기존 모델을 파인튜닝하려는 기업들에게 큰 비용 절감 효과를 제공할 수 있다는 점에서 의미가 깊다.

IBM 클라우드 인프라 총괄인 사틴더 세티(Satinder Sethi)는 “AI 도입을 위한 더 많은 선택권과 더 낮은 진입 장벽은 전 세계 고객에게 실질적인 가치를 제공할 것”이라며, “가우디 3 기반 플랫폼은 고객의 AI 여정을 더 자유롭고 경제적으로 만들어 줄 것”이라고 강조했다.

이번 협력을 통해 인텔은 AI 가속기 시장에서 엔비디아 중심의 독점 구도에 도전장을 내밀며, ‘개방성과 효율성’이라는 키워드로 시장을 재편하고자 하는 전략을 가속화하고 있다.

헬로티 서재창 기자 |