테크노트 KAIST, 내 PC·모바일도 AI 인프라로...챗GPT 비용 낮춘다

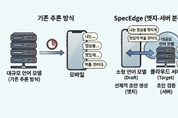

국내 연구진이 비싼 데이터센터 GPU를 덜 쓰고, 주변에 있는 저렴한 GPU를 활용해 AI 서비스를 더 싸게 제공할 수 있는 기술을 개발했다. 대규모 언어 모델(LLM) 기반 AI 서비스는 지금까지 대부분 고가의 데이터센터 GPU에 의존해 왔다. 이로 인해 서비스 운영 비용이 높고, AI 기술 활용의 진입장벽도 컸다. 한국과학기술원(KAIST)은 전기및전자공학부 한동수 교수 연구팀이 데이터센터 밖에 널리 보급된 저렴한 소비자급 GPU를 활용해 LLM 인프라 비용을 크게 낮출 수 있는 새로운 기술 ‘스펙엣지(SpecEdge)’를 개발했다고 28일 밝혔다. SpecEdge는 데이터센터 GPU와 개인 PC나 소형 서버 등에 탑재된 ‘엣지 GPU’가 역할을 나눠 LLM 추론 인프라를 함께 구성하는 방식이다. 연구팀에 따르면 이 기술을 적용한 결과, 기존 데이터센터 GPU만 사용하는 방식에 비해 토큰(AI가 문장을 만들어내는 최소 단위)당 비용을 약 67.6% 절감할 수 있었다. 연구팀은 이를 위해 ‘추측적 디코딩(Speculative Decoding)’이라는 방법을 활용했다. 엣지 GPU에 배치된 소형 언어모델이 확률이 높은 토큰 시퀀스(단어 또는 단어 일부가 순서