4차 산업혁명 시대가 도래하면서 공정에 AI 기술을 접목해 더 똑똑하고 효율적인 제조가 가능해졌다. AI 기술을 접목하면 완벽한 불량 검사, 폭발적인 생산성 증가가 가능할 것처럼 느껴지지만, 실제 산업체 공정에 AI 응용상용화를 할 경우 85%는 실패하는 것으로 나타났다. 우리는 AI를 너무 과대평가하고 있는 건 아닐까?

PoC 성공이 응용상용화 직결은 아니다

설계 개발, 생산 계획, 양산 공정, 검사, 출하 등의 생산 공정에 AI 기술을 접목하면 자동설계를 통해 다모델을 개발할 수 있다. 단순한 부업무인 육안검사가 줄어들고 불량원인 파악에 집중되는 업무를 효율화할 수 있다.

웨이퍼 등 방대한 양의 품질검사를 진행할 때 사람 대신 AI를 활용하면 인건비는 줄이고 검사 정확도는 상승하기 때문에 ROI도 커진다. AI 기술은 생산 공정의 효율성을 높여주기 때문에 접목만 하면 성공할 것처럼 느껴진다.

LG CNS 연구소의 조사 결과에 따르면, 100여 건의 R&D PoC 중 다수가 성공했지만 응용상용화를 적용한 비율은 30%에 그쳤다. 즉, PoC에 성공해 기술적으로 입증이 됐을지는 몰라도 양산 단계까지 이어지지 못하는 경우가 대다수라는 것이다. 우리는 현시점의 AI 수준에 비해 더 많은 기대를 하고 있는지도 모른다.

몇 차례의 암흑기를 거친 AI, 2021 세 번째 겨울 오나?

1956년 AI 개념이 정립되면서 인간 수준의 인공지능 혹은 그 너머의 슈퍼AI 등 AI에 대한 연구와 기대는 커졌다. AI 첫 번째 겨울 1970년에 마빈 민스키는 “인간은 생각하는 기계다”라고 이야기했고, 1990년 두 번째 겨울에 Expert System이 등장했다.

하지만 그럼에도 가격 대비 성능은 낮고, 업데이트는 많아 복잡성 문제가 존재했다. 이 AI 암흑기에 제프리 힌튼 교수가 심층학습(Deep Learnig)을 내세우면서 다시 한번 AI에 부흥기를 이끌었고, 2021년 AI 산업 침체의 주요인으로 ‘레이블링 불가, 소량 데이터’가 떠올랐다.

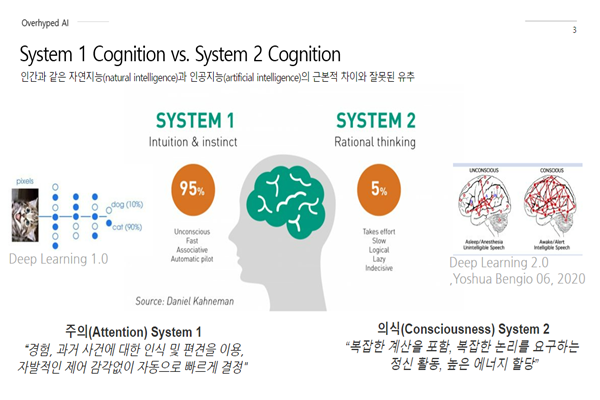

Daniel Kahneman은 AI를 크게 System1 Cognition, System2 Cognition으로 분류했다. System1은 직관적인 주의(Attention) System이다. 겅험, 과거 사건에 대한 인식 및 편견을 이용해 자발적인 제어 감각 없이 자동으로 빠르게 결정한다. System2는 의식(Consciousness)으로 결정하는 것이다. 복잡한 계산을 포함해 복잡한 논리를 요구하는 정신 활동, 높은 에너지 할당을 요구한다.

Yoshua Bengio는 “지금의 우리가 말하는 딥러닝은 딥러닝 1.0이고 이 system2의 의식으로 결정하는 시스템이 우리가 미래에 가야 할 딥러닝 2.0”이라고 주장한다.

현재 딥러닝1.0의 잠재력은 의미(단어, 픽셀, 소리 간)를 가지는 데이터의 통계적 상관성을 이용해 비선형 기하공간을 포착한 수준에 불과하다. 인간의 객체인식을 AI가 ‘공간상관성’으로 포착하고, 인간의 음성인식을 ‘자기상관성’으로 포착하는 단계다.

심층학습의 ‘딥’이 굉장히 많은 역할을 수행할 것 같지만 현실은 그렇지 못한다. 케라스 딥러닝 라이브러리 창시자인 프랑소와 숄레는 지금 수준의 딥러닝을 딥러닝이란 표현보다 ‘계층적/위계적 표현학습’이란 표현이 더 적절하다고 말한다.

딥러닝에 열광하는 이유, AI 현 수준의 비판

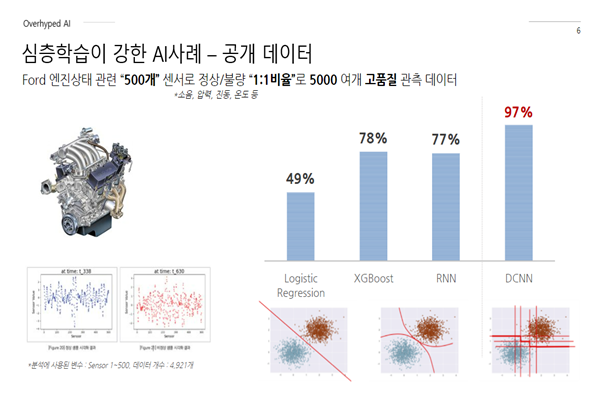

공개된 데이터를 통해 딥러닝의 성공 사례를 살펴보면 Ford 엔진 상태 검사를 예시로 들 수 있다. 관련 500개 센서로 정상/불량을 1:1 비율로 5000여개 고품질 관측 데이터를 측정했을 때, 기존 전통적인 기법 Model-Centric은 사람이 뒷받침해야 하는 조건이 있지만, 딥러닝은 한 번에 결과값이 나온다. 딥러닝에 열광할 수밖에 없는 대표적인 사례다.

이런 딥러닝 열광 상황 속 AI 현 상황에 대한 노골적인 비판이 나왔다. The Economist에서 Gary Marcus는 “실제로 AI를 현장에 적용하려고 하지만 활용할 데이터가 너무 적으며, 투자 대비 효용이 높지 않다”고 말했다.

이어 딥러닝의 한정적인 데이터에 대해 1)딥러닝은 대량의 레이블 데이터가 반드시 필요 2)인간 수준의 전이학습은 불가능 3)의식의 흐름 구조 4)데이터 셋 범위를 벗어난 추정은 어려움 5)데이터 셋의 편향된 학습 6)사전지식 숙지의 어려움 7)진정한 의미 파악의 어려움 8)오염 데이터에 매우 약함 9)잘못된 레이블 10)설명 가능 모델 등으로 딥러닝의 한계를 얘기했다.

산업 AI의 데이터 품질 과제 ①부족한 데이터

가트너 조사 결과에 따르면 낮은 데이터 품질로 수리통계적 학습이론의 과정을 위반할 경우 80~87% AI 프로젝트가 실패한다. 적은 데이터는 ‘시행착오 중심 판단기술’을 적용할 수 없다. 또한 현실은 label 하지 않은 것도 큰 변수 중 하나다. 관측 데이터는 항상 오염돼 있으며, 집합이 동일 확률분포도 아니다. 또한 실제 영향력을 가진 다른 잠재변수들이 존재하는 등의 과제가 존재한다.

Andrew Ng은 “데이터의 노이즈를 제거한 Clean Labels를 만들거나, High-Quality Labels를 새로 수집해야 한다”고 말하며, 모델의 미미한 개선을 하기보다 고품질 데이터에 초점을 맞추는 것이 합리적이라고 말한다. 데이터를 어떻게 전처리하는지, 어떻게 데이터를 모았는지, 크기가 어떤지, 얼마나 품질이 좋은지, 어떻게 학습/평가 셋을 나누었는지 등이 AI 시스템 개발에 큰 영향을 끼친다는 것이다.

산업 AI의 데이터 품질 과제 ②오염된 데이터

오염된 관측 데이터는 Data Cleaning 기법을 사용해 가공해야 한다. 인간의 시각은 자동으로 고수준 노이즈를 제거하지만, 인공지능은 Cleaned Data화가 항상 필요하다. 비지도학습의 경우 지도학습에 비해 훨씬 더 취약하다.

또한 수작업 Label들은 대부분 오류를 포함하고 있기 때문에 오염된 Label은 제거해 성능을 개선 시켜야 한다. 검사를 통해 패턴 오류를 잡아도 실제와 다른 경우가 많다. 패턴과 관련된 다른 상관성 높은 작업인 경우가 많은 것이다. 즉, 정확하게 원인 인자를 잡는 것이 난제다.

데이터를 어떻게 이해하고 처리할 것인가

관건은 앞단 데이터를 어떻게 이해하고 처리하느냐이다. AI 요구사항도 비슷하다. 예를 들어 웨이퍼 공정 검사를 진행하면 정상 데이터가 훨씬 많이 나오고 불량 데이터는 적게 나온다.

저성능 원인을 분석하면 1)타 클래스간 입력 피처 유사성이다. 입력값은 유사하지만, Label이 달라 분류기의 결정경계 신뢰도가 매우 낮기 때문이다. 2)비선형 결정경계다. High-Capacity Model일수록 입력데이터의 미세한 변화가 성능에 큰 영향을 미친다.

3) non I.i.d(independent and identicalluy distributed) 훈련 트레이닝 데이터 셋과 실제 테스트, 응용상용화했을 때 데이터 분포가 동일해야 한다. 학습 셋과 테스트 셋 분포가 같아야 한다는 것이다. Model-Centric AI 기반 최적화된 분류모델보다, Data-Centric Approach로 처리한 분류모델이 더 높은 성능을 보였다.

1%의 데이터 연구

Andrew Ng은 “세계 최고 전문의를 능가한다는 논문은 가능하지만, 실제 환경에서의 동작은 대부분 어렵다”라고 말한다. 실제 현장도 마찬가지다. 공정 오류를 검사했을 때 테스트 값이 잘 나왔어도, 심층학습 기반 PoC를 확보해 양산해 보니 값이 엉망진창인 경우가 대다수다.

이는 실제 계측기 자체가 불확실성을 가지고 있기 때문이다. 초고가의 동일한 계측장비에 동일한 설정을 하더라도 ‘물리적인 내재적 불확실성’이 항상 존재하기 때문이다. 검사 시 우리는 불량이라는 주 효과만 변하기를 원하지만 실제로는 온도, 장비설정, 튜닝, 물성치 등 요인 또한 틀어지기 때문이다.

두 번째는 Open-Set Recognition 문제다. 동일한 Label이더라도 ‘물리적 불량원인계’가 다르면 분포가 달라 Supervised Learnig으로 B,C 분포 학습 시 A 분포의 불량은 탐지할 수 없는 것이다.

세 번째는 Concept Drift다. 시간에 따라 대상의 속성이 변한다는 것이다. ‘통계적 속성의 변경(배터리 물성치 전이)’에 의해 데이터 패턴이 변경되는 현상이 존재한다.

하나의 클래스마다 군집성을 가진다. 통계적으로 가지는 유사성을 통해 테스트를 할 수 있는 것이다. 이상적인 학습데이터는 Systematic Effect으로 Label마다 통계적 속성이 동일한 고품질의 학습데이터를 랜덤샘플링을 통한 7:3 분할 시 동일한 분포를 가지는데, 실제 학습 데이터는 Random Defect로 각 정상 클러스터 규모에 비례하게 불량이 발생한다. Random Defect는 선택한 피처가 물리적 불량과 상관성이 있는 통계적 속성인 패턴이 있다고 보기는 어렵다.

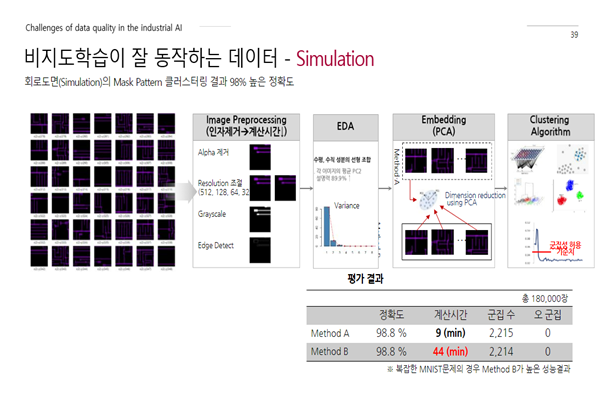

예시를 들자면 비지도학습으로 현장에 적용했는데, 회로도면(Simulation)의 Mask Pattern 클러스팅 결과 98% 높은 정확도를 보여줬다. 하지만 camera axis alignment error 등의 현실적인 문제점들이 비지도학습이론의 가정을 위반해 결괏값이 안 나오는 경우가 발생한다.

이를 해결하기 위한 SOTA Algorithm을 말하는 경우가 있는데. 이 알고리즘은 잘 알려진 공개된 데이터에서는 지도학습에 가까운 0.88~0.90 정확도를 보이지만, 복잡다단한 현실 문제에서는 기대한 만큼의 성능이 나오지 않는다.

Andrew Ng은 “AI 성능은 코드(모델)가 아니라 데이터 개선에 달렸다. 99% 연구가 모델 관련이며, 1%만이 데이터 내용이다”라고 말했다. AI 성능은 모델 연구에 치중되어 왔는데 현시점에서 AI 성능 개선을 위해서는 데이터 연구에 집중해야 한다.

어떤 데이터를 어떻게 학습하고 관찰할 것인가

그렇다면 데이터 연구를 어떻게 해야 할까? 중요한 것은 ‘어떤 데이터를 어떻게 학습하고 관찰할 것’인지다.

▲Automatic Machine Learning- 성능 영향력이 높은 요소를 찾는 것이다. 어떤 데이터를 학습할 것인지를 명확히 찾아야 한다. ▲Statistical Machine Learning-학습이론을 명확하게 파악해야 한다. 다양한 상황에 적용 가능한 일반적인 시스템을 원하지만 현실은 제한된 상황에서 특정한 사례를 학습시킬 수 있는 수준이기 때문이다. ▲단순 관측은 모호한 학습데이터를 생성한다.

자연의 데이터생성프로세스(DGP)는 수리통계적 확률 프로세스 가정을 자주 위반한다. 모호한 관측을 통해 데이터를 취합하게 되면 많은 원인 인자들이 누락하게 된다. 관측(데이터)의 1차 정보손실은 모델의 2차 정보손실로 이어진다. 표면 현상 직관에 현혹돼, 상관으로 왜곡된 인과를 추정하게 되고 편향된 샘플이 나오게 된다.

헬로티 함수미 기자 |